Многие блогеры ищут ответ на такой вопрос: «Как избавиться от дублей страниц?», для того, чтобы удалить дубли страниц своего сайта из результатов выдачи поисковых систем. Дублированные страницы попадают в индекс поисковых систем, где они присутствуют наряду с основной продвигаемой страницей.

Таких страниц может быть очень много, при этом, поисковая система должна будет ранжировать одинаковые страницы в поисковой выдаче. За это поисковая система может наложить санкции на основную страницу, понижая ее в поисковой выдаче. Таким образом, дубли страниц оказывают вредное воздействие на продвижение страниц сайта в поисковой системе.

Дублированные страницы могут копировать полное содержание, или только частичное содержание основной страницы. В частности, CMS WordPress сама создает, в некоторых случаях, дублированные страницы, например, всем известный «replytocom» (комментарий, ответ на комментарий, реплика).

Если на вашем сайте включены древовидные комментарии, то в этом случае, каждый комментарий будет создавать дубль страницы. Поэтому, если дубли страниц сайта присутствуют в индексе поисковых систем, то тогда необходимо будет удалить такие страницы из результата выдачи поисковиков.

Наличие дублированных страниц в поиске, вредит сайту при его продвижении в поисковых системах. Поисковые системы понижают позиции сайта, уменьшается так называемый вес страницы, ухудшается индексация сайта и т. п.

Поисковая система Google обращает особое внимание на наличие дублей страниц, понижая позиции сайта при наличии большого их количества. Я не буду больше теоретизировать на эту тему, а лучше расскажу вам о том, как я борюсь с дублями страниц, на примере своего сайта — vellisa.ru.

- Моя история борьбы с дублями страниц

- Поиск дублей страниц

- Запрет на индексацию в файле robots.txt

- Добавление параметра replytocom в инструменты для веб-мастеров

- Плагин WordPress Thread Comment для древовидных комментариев

- Плагин WordPress SEO by Yoast для удаления replytocom

- 301 редирект для удаления replytocom

- Настройки SEO плагина

- Удаление дублей страниц вручную

- Как удаляются дубли на моем сайте

- Еще один способ для борьбы с дублями страниц

- Выводы статьи

Моя история борьбы с дублями страниц

В самом начале весны 2013 года моему сайту исполнился год, в это время посещаемость сайта составляла примерно 2000 посетителей в сутки. Затем посещаемость на сайте начала резко падать. Уже в середине мая посещаемость едва превышала 1000 посетителей в сутки.

Весной 2013 года у многих блогеров, в связи с вводом новых алгоритмов, понизилась посещаемость с Гугла. На моем сайте посещаемость с поисковика Google уменьшилась примерно на 40%. В моем случае, на спад посещаемости повлиял ввод новых алгоритмов, а также некоторые изменения, которые я сделал в то время на своем сайте.

Подумав, я решил вернуть прежнюю посещаемость для своего сайта. За лето я выполнил эту задачу, в сентябре моему сайту удалось опять выйти на среднюю посещаемость в 2000 посетителей в сутки. Далее посещаемость моего сайта продолжила увеличиваться.

Вроде бы все хорошо, но дело в том, что рост посещаемости произошел, в основном, за счет поисковой системы Яндекс. Если раньше соотношение посетителей пришедших на сайт с поиска Яндекса и Google, было 3 к 1 (примерное соотношение, грубо) в пользу Яндекса, что примерно соответствует доле поисковых систем в Рунете, то затем такое соотношение возросло до 5 к 1. Появилась сильная зависимость от одной поисковой системы.

Посещаемость с Гугла росла очень медленно, только весной 2014 года она достигла уровня прошлого года. А ведь в это время, целый год, я писал новые статьи. Получается, что Яндекс адекватно реагировал на добавление новых статей на сайте, чего не скажешь о Google.

В декабре 2013 года мне пришлось установить на свой сайт новый шаблон, так как на прежней теме, у меня не получалось изменить структуру своего сайта. Эти действия мне необходимо было сделать в любом случае.

После этого я обратил внимание на дублированные страницы в индексе поисковых систем. До этого я знал об этой проблеме, читал о способах ее решения, но пока ничего не предпринимал.

Я, в любом случае, не стал бы отключать на своем сайте древовидные комментарии, потому что из-за этого будет неудобно посетителям сайта, а также я не хотел использовать плагины для удаления дублей страниц.

В итоге, в файл htaccess был установлен код, а из файла robots.txt были удалены некоторые директивы (подробнее, что я делал, расскажу ниже). Постепенно, в результатах выдачи поисковых систем уменьшилось количество дублированных страниц моего сайта.

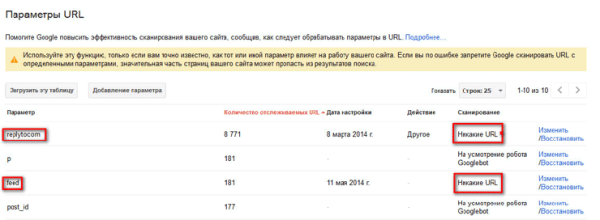

В марте 2014 года я добавил параметр «replytocom» в инструменты для веб-мастеров Google, а в мае я добавил туда еще один параметр: «feed».

На данный момент, на моем сайте не осталось дублей страниц в результатах выдачи поисковой системы Google, которые имеют в своем адресе переменную replytocom, а ведь раньше таких страниц там было огромное количество (несколько тысяч).

Наконец, я был приятно удивлен возросшей, примерно в 2 раза посещаемостью с Гугла. Теперь соотношение между поисковыми системами стало около 2 к 1 в пользу Яндекса.

Таким образом, на собственном опыте, я узнал о том, какое влияние может оказать на продвижение сайта, наличие дублей страниц в индексе поисковой системы.

Правда, здесь необходимо будет учитывать, что поисковые системы ранжируют страницы в результатах выдачи по многим параметрам. Поэтому у вас, может быть, не произойдет значительный рост посещаемости вашего сайта. В любом случае, удаление дублей страниц из результатов поисковой выдачи, скажется благоприятно на вашем сайте.

Поиск дублей страниц

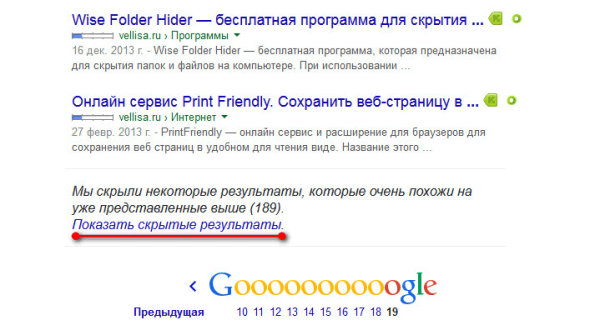

Для поиска дублей страниц на своем сайте, введите в поисковую строку такое выражение — «site:vellisa.ru» (вместо «vellisa.ru» введите название своего сайта). Перейдите на последнюю страницу поисковой выдачи, у меня, в данном случае, это 19 страница. Запомните номер этой страницы, чтобы потом вы могли быстро перейти к этой странице.

На последней странице поисковой выдачи, ниже последнего результата выдачи, вы увидите объявление, в котором вам сообщают, что поисковая система скрыла некоторые результаты, которые очень похожи на уже представленные выше. Далее нажмите на ссылку «Показать скрытые результаты».

После этого опять будет открыта первая страница поисковой выдачи. Сразу переходите к той странице, которую вы запомнили, в моем случае, это 19 страница. На этой, или на следующей странице, вы увидите дублированные страницы своего сайта.

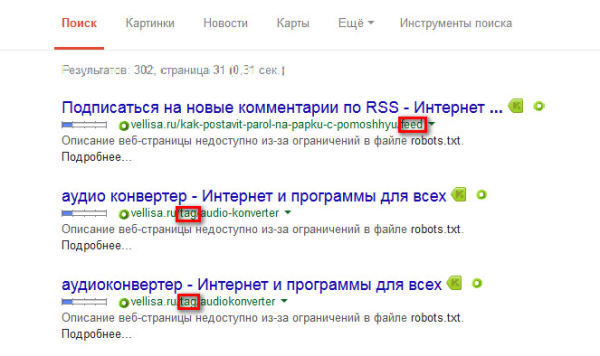

На этом изображении видны такие дублированные страницы, которые имеют в URL ссылки «feed» и «tag». Также в результатах поисковой выдачи могут присутствовать дубли с «replytocom», «page» и с некоторыми другими параметрами.

Другой большой проблемой, если на сайте используются древовидные комментарии, является наличие огромного количества страниц с переменной replytocom, которые генерирует сама CMS WordPress.

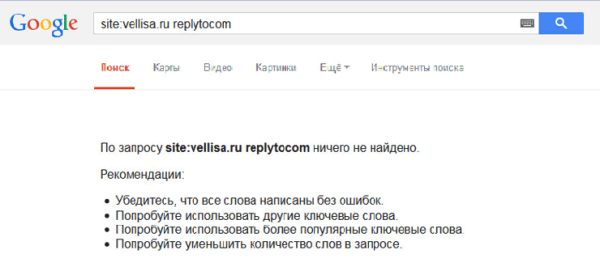

Проверить наличие страниц с replytocom можно таким образом: введите в поисковую строку Google выражение — «site:vellisa.ru replytocom» (без кавычек). Вместо «vellisa.ru» вставьте название своего сайта.

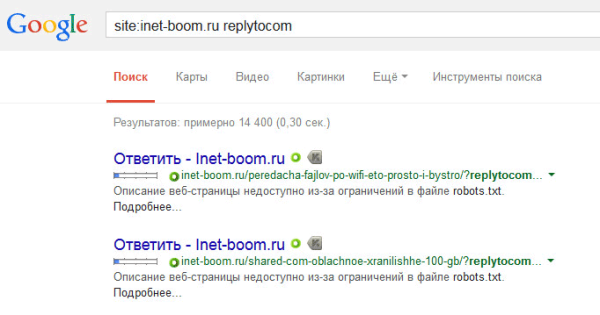

На моем сайте дублированных страниц с replytocom нет, несмотря на то, что на моем сайте присутствуют древовидные комментарии. Для примера я возьму сайт одной моей подруги Юлии (inet-boom.ru), надеюсь, что она за это на меня не обидится.

На этом изображении, в самом конце ссылки, после адреса страницы, вы увидите такое окончание ссылки — «?replytocom=3734». Цифры в конце адреса будут меняться в зависимости от номера комментария.

Таких страниц в индексе поисковой системы может быть огромное количество. Поэтому с дублями replytocom нужно будет бороться.

Что необходимо будет сделать?

- Проверить наличие дублированных страниц в индексе поисковых систем.

- Закрыть необходимые параметры от индексации в файле robots.txt.

- Добавить необходимые параметры в панель для веб-мастеров Google.

Эти требования нужно будет выполнить в обязательном порядке. Остальные действия будут зависеть от того способа, который вы выберите для борьбы с дублями страниц.

Вам нужно будет добавить свой сайт в инструменты для веб-мастеров Google и Яндекса, для того, чтобы решать проблему избавления от дублей страниц с помощью этих инструментов поисковых систем.

Запрет на индексацию в файле robots.txt

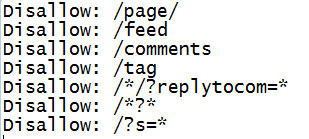

Для запрета на индексацию определенных параметров, которые оказывают влияние на появление дублированных страниц в поиске, вносятся директивы в файл robots.txt. При использовании директивы Disallow дается команда поисковым роботам для запрещения индексирования.

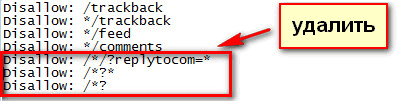

Команды на запрещение индексации в файле robots.txt могут выглядеть примерно так (на этом примере часть файла):

Директивы со знаком вопроса (?) обычно присутствуют, если на сайте созданы так называемые ЧПУ ссылки, при помощи которых изменяется URL веб-страницы. Здесь также присутствует команда на запрет на индексацию ссылок с переменной replytocom.

Если поисковая система Яндекс, в целом, выполняет директивы, внесенные в файл robots.txt, то с поисковой системой Google все намного сложнее. Роботы Гугла индексируют все, невзирая на запреты, прописанные в файле robots.txt.

В плагинах для SEO оптимизации присутствует возможность закрытия тегом «noindex» рубрик, меток, архивов, страниц поиска и т. д. Правда, не всегда эти указания выполняются поисковыми роботами.

Добавление параметра replytocom в инструменты для веб-мастеров

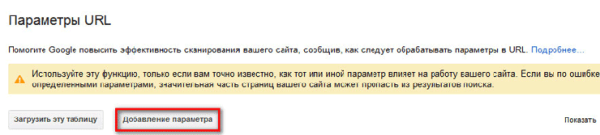

В Google webmaster tool войдите на страницу «Инструменты для веб-мастеров». В правой колонке «Панель инструментов сайта», сначала нажмите на кнопку «Сканирование», а затем нажмите на кнопку «Параметры URL».

На этой странице вы можете добавить новые параметры или изменить уже добавленные, для обработки поисковыми роботами Google. В зависимости от настроек, поисковый робот Googlebot будет игнорировать определенные параметры при внесении страниц сайта в индекс поисковой системы.

- Для добавления нового параметра нажмите на кнопку «Добавление параметра».

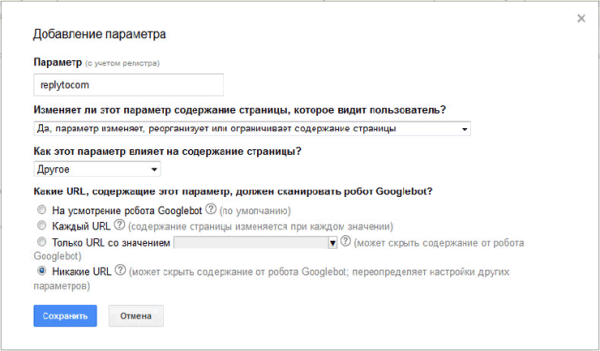

- После этого открывается окно «Добавление параметра».

- В поле параметр (с учетом регистра) добавляете новый параметр, в данном случае «replytocom».

- На вопрос: «Изменяет ли этот параметр содержание страницы, которые видит пользователь?», отвечаете: «Да, параметр изменяет или реорганизует или ограничивает содержание страницы».

- При ответе на вопрос: «Как этот параметр влияет на содержание страницы?», выбираете вариант ответа: «Другое».

- На вопрос: «Какие URL, содержащие этот параметр, должен сканировать робот Googlebot», отвечаете: «Никакие URL».

- Затем нажимаете на кнопку «Сохранить».

Подобным образом вы можете добавить и другие параметры. Если параметр уже присутствует в списке, то для изменения его настроек необходимо будет нажать на ссылку «Изменить».

После добавления параметра replytocom в панель для веб-мастеров, из файла robots.txt потребуется удалить примерно такую директиву «Disallow: /*?replytocom» (если она присутствует в файле роботс) для того, чтобы googlebot переходил по ссылкам с этим параметром, и удалял их из индекса.

Если на вашем сайте нет дублей страниц с таким параметром, то тогда вам можно будет оставить такую директиву в файле robots.txt.

Постепенно дублированные страницы будут удаляться из индекса поисковой системы. Если дублированных страниц очень много, то в этом случае, процесс удаления дублей страниц будет происходить достаточно длительное время, возможно даже, в течение нескольких месяцев.

Плагин WordPress Thread Comment для древовидных комментариев

Так как, появлению replytocom способствуют древовидные комментарии, то некоторые пользователи вообще отключают их на своем сайте. После отключения древовидных комментариев, особенно, если статьи на сайте активно комментируются, получается очень неудобная навигация. Посетителю, подчас вообще непонятно, кто, где, кому, что ответил.

Плагин WordPress Thread Comment решает проблему древовидных комментариев в WordPress. Древовидные комментарии остаются на сайте, при этом переменные replytocom не добавляются. Плагин выводит ссылку с комментария через javascript, поэтому поисковые роботы не индексируют эту ссылку.

Новые переменные replytocom появляться в индексе поисковика уже не будут, а старые переменные придется постепенно удалить из индекса поисковой системы.

Мне лично в этом плагине не понравился внешний вид комментариев. Я не стал использовать этот плагин на своем сайте. Замечу, что плагин WordPress Thread Comment для борьбы с replytocom, рекомендовал использовать Александр Борисов.

Плагин WordPress SEO by Yoast для удаления replytocom

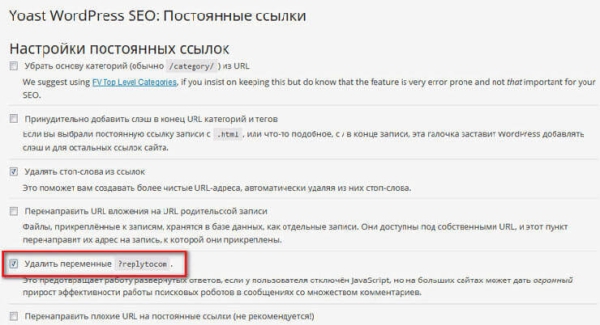

Плагин WordPress SEO by Yoast, довольно мощный плагин для SEO оптимизации сайта, кроме всего прочего, позволяет удалить с сайта переменные replytocom. При этом, древовидные комментарии останутся на вашем сайте.

После установки плагина WordPress SEO by Yoast на свой сайт, в настройках плагина, в разделе «Постоянные ссылки», необходимо будет активировать пункт «Удалить переменные ?replytocom».

После этого, постепенно дублированные страницы с «соплями» replytocom будут удаляться из индекса Google.

Так как, на моем сайте установлен плагин All in One SEO Pack, и по некоторым причинам, я пока не хочу переходить на плагин WordPress SEO by Yoast, то я не стал использовать этот вариант, для борьбы с дублями страниц.

301 редирект для удаления replytocom

Это, наверное, самый радикальный способ борьбы с replytocom. Я использовал именно этот метод.

После смены шаблона, Лариса Web-Кошка предложила мне использовать 301 редирект для борьбы с дублями replytocom. До смены шаблона на сайте, я не решался использовать этот метод.

Теперь я могу сказать, что при использовании 301 редиректа, а также после некоторых действий, о которых я напишу ниже, мой сайт успешно справился с дублями replytocom.

На этом изображении вы можете увидеть, что на моем сайте нет дублированных страниц с переменной replytocom, несмотря на то, что на моем сайте присутствуют древовидные комментарии, без использования специальных плагинов.

Для использования 301 редиректа потребуется вставить специальный код в файл «htaccess», который находится в корневой папке вашего сайта. Корневая папка сайта — это та папка вашего сайта, в которой находятся папки «wp-admin», «wp-content», «wp-includes» и т. д.

В файл htaccess, ниже строки «RewriteBase /», необходимо будет вставить такой код:

RewriteCond %{QUERY_STRING} replytocom= RewriteRule ^(.*)$ /$1? [R=301,L] Внимание! До начала вставки этого кода оригинальный файл htaccess на своем компьютере. Если вы совершите ошибку, что-то пойдет не так, то тогда вы сможете заменить модифицированный файл htaccess на оригинальный файл, используя для этого файловый менеджер на своем хостинге, или через FTP при помощи программы FileZilla.

При возникшей неполадке, вместо своего сайта вы можете увидеть «белый экран смерти». Замена модифицированного файла на оригинальный файл htaccess, вернет работоспособность вашему сайту.

После вставки кода нужно будет проверить работу 301 редиректа. Для этого, сначала необходимо будет вставить в адресную строку браузера ссылку, содержащую replytocom, а затем проверить результат перехода. После перехода, ссылка на открытой веб-странице должна будет поменяться на оригинальную ссылку, не содержащую в URL переменной replytocom.

Далее необходимо будет сделать еще две вещи. Сначала нужно будет удалить из файла robots.txt директивы, содержащие запрет на индексацию страниц со знаком вопроса. Директивы удаляются в том случае, если вы будете использовать этот метод.

Затем необходимо будет добавить параметр replytocom в «Инструменты для веб-мастеров Google», как это сделать я написал выше в статье.

Настройки SEO плагина

Для предотвращения индексации страниц архивов, рубрик, меток, 404 страниц, страниц поиска, пагинации (постраничной навигации), в плагине All in One SEO Pack необходимо будет активировать пункты для добавления аргументов noindex, follow и noindex, nofollow (для постраничной навигации).

В плагине WordPress SEO by Yoast параметры индексирования для поисковых роботов будут выглядеть таким образом: noindex, follow.

Теперь, вам потребуется запастись терпением, и подождать когда Гугл удалит дублированные страницы из своего индекса. Если вы не хотите долго ждать, или если на вашем сайте осталось совсем немного дублированных страниц, то тогда вы можете ускорить их удаление.

Удаление дублей страниц вручную

Вы можете вручную добавить ссылки на дубли страниц в «Инструменты для веб-мастеров» для их удаления из индекса поисковой системы. Когда на моем сайте, в выдаче поисковой системы, осталось не так много дублированных страниц, я также вручную добавил найденные результаты, для более быстрого их удаления из индекса.

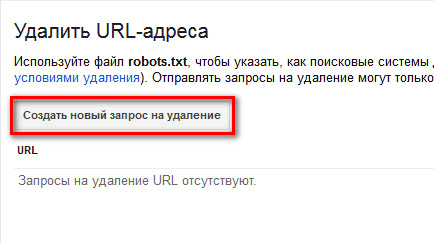

- На странице «Инструменты для веб-мастеров», в правой колонке «Панель инструментов сайта», сначала нажмите на кнопку «Индекс Google», а затем нажмите на кнопку «Удалить URL-адреса».

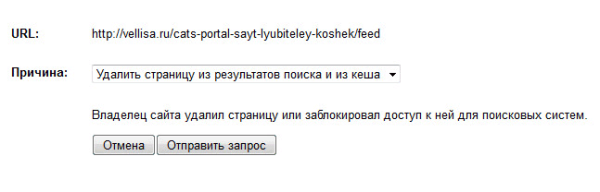

- Далее будет открыта страница «Удалить URL-адреса». На этой странице нужно будет нажать на кнопку «Создать новый запрос на удаление».

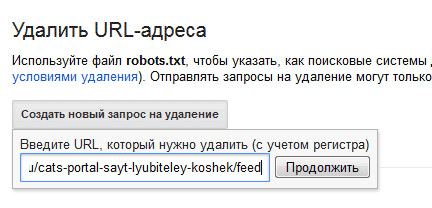

- Под кнопкой откроется поле, в которое следует вставить ссылку. После этого нужно будет нажать на кнопку «Продолжить».

- Далее откроется новая страница, на которой будет отображен удаляемый URL. В пункте «Причина» выберите такой вариант: «Удалить страницу из результатов поиска и из кеша». Затем нажмите на кнопку «Отправить запрос».

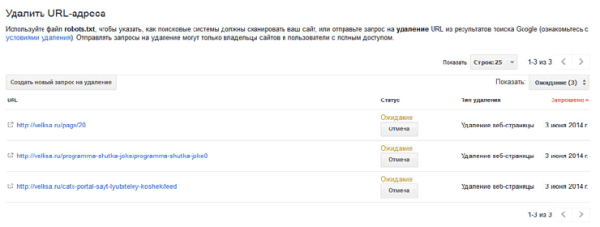

- На странице «Удалить URL-адреса» вы увидите добавленные ссылки, которые ждут очереди на удаление. Точно таким способом, вы можете добавить следующую ссылку для ее удаления из результатов поиска и из кеша поисковой системы Гугл.

Проблема существует, она может оказывать негативное влияние на продвижение сайта, поэтому администратору сайта нужно будет избавиться от дублей страниц для получения положительного результата.

Прошел месяц со дня опубликования этой статьи, теперь настало время дополнить публикацию новой информацией.

Как удаляются дубли на моем сайте

Сейчас я расскажу, как именно, в данный момент, осуществляется борьба с дублями страниц на моем сайте.

- Я удалил из файла robots.txt некоторые запрещающие директивы, для того, чтобы открыть доступ поисковым роботам к определенным директориям моего сайта.

- В плагине для СЕО оптимизации (AIOSP), мной были отмечены пункты для добавления мета тега роботс для соответствующих страниц сайта. Поисковый робот переходя на такую страницу увидит запрещающий метатег и не будет индексировать данную страницу.

Для этого был открыт доступ к определенным страницам в файле robots, для того, чтобы робот перешел на данную страницу, и увидел такие метатеги:

meta name="robots" content="noindex,nofollow" meta name="robots" content="noindex,follow"

Поэтому поисковый робот не будет индексировать страницу с такими метатегами. Ранее попавшие в индекс страницы, будут постепенно удалены из выдачи поисковых систем.

- Были добавлены параметры replytocom в панель веб-мастера Google.

- Мною был добавлен следующий код в файл htaccess:

RewriteCond %{QUERY_STRING} replytocom= RewriteRule ^(.*)$ /$1? [R=301,L] RewriteRule (.+)/feed /$1 [R=301,L] RewriteRule (.+)/comment-page /$1 [R=301,L] RewriteRule (.+)/trackback /$1 [R=301,L] RewriteRule (.+)/comments /$1 [R=301,L] RewriteRule (.+)/attachment /$1 [R=301,L] RewriteCond %{QUERY_STRING} ^attachment_id= [NC] RewriteRule (.*) $1? [R=301,L]В этот код вошли 301 редирект с replytocom, а также редиректы с другими параметрами, которые я взял с сайта Александра Борисова. Как я понял, автором редиректов для других параметров является известный блогер Александр Алаев (АлаичЪ).

Из файла robots.txt были удалены соответствующие директивы (feed, comments, trackback и т. п.) для параметров, которые были добавлены в файл htaccess.

После этого, поисковый робот переходя на дублированную страницу, которая имеет в URL адресе такие параметры, будет перенаправлен с помощью 301 редиректа на оригинальную страницу моего сайта.

- В файл functions.php был добавлен код для предотвращения появления новых дублей с replytocom, который нашел в интернете посетитель моего сайта, Антон Лапшин:

function replace_reply_to_com( $link ) { return preg_replace( '/href='(.*(?|&)replytocom=(d+)#respond)/', 'href='#comment-$3', $link );} add_filter( 'comment_reply_link', 'replace_reply_to_com' );Этот код нужно будет вставить в файл «Функции темы» (functions.php) перед закрывающим тегом ?>.

После вставки кода, при наведении курсора мыши на кнопку «Ответить» в комментариях, в ссылке, которая будет видна в левом нижнем углу окна браузера, теперь не будет появляться переменная replytocom. Следовательно, новые ссылки с этим параметром не будут добавляться в индекс поисковых систем.

Перед внесением изменений, не забудьте сделать резервную копию файла «Функции темы».

Все эти настройки работают, в основном, для поисковой системы Google. В Яндекс соотношение количества загруженных роботом страниц и страниц в поиске на моем сайте, на данный момент, оптимальное.

Еще один способ для борьбы с дублями страниц

Я нашел в интернете еще один способ для удаления дублей страниц из поисковой выдачи. С помощью кода на определенные страницы сайта будет добавлен мета тег роботс noindex, nofollow для запрещения индексации таких страниц.

Данный код вставляется в файл functions.php сразу за <?php для добавления на определенные страницы мета тега роботс noindex, nofollow. В этом коде запрещается индексация страниц с категориями, архивами, архивами по годам, по месяцам, по дням, по датам, по авторам, метками (тегами), таксономии произвольных типов записей, страницы с прикрепленными файлами, постраничной навигации (пагинации), фида, внутреннего поиска.

function meta_robots () { if (is_archive() or is_category() or is_feed () or is_author() or is_date() or is_day() or is_month() or is_year() or is_tag() or is_tax() or is_attachment() or is_paged() or is_search()) { echo "".'<meta name="robots" content="noindex,nofollow" />'."n"; } } add_action('wp_head', 'meta_robots');После добавления этого кода, в плагине для SEO оптимизации необходимо будет отключить добавление мета тега роботс к данным страницам. В плагине All in One SEO Pack — раздел «настройки индексирования (noindex)».

Затем необходимо будет убрать из файла роботс соответствующие запрещающие директивы.

Таким способом можно будет закрыть от индексации необходимые страницы. Только для избавления от дублей replytocom необходимо будет использовать один из методов, которые описаны в этой статье. Кроме использования редиректа и плагинов, также еще можно будет заключить ссылки с комментариев в тег span, для того, чтобы они не индексировались поисковыми системами.

После завершения настроек, вам нужно будет, время от времени, следить за процессом удаления дублей страниц с вашего сайта.

Выводы статьи

Вебмастеру следует обратить внимание на наличие дублей страниц сайта, и в случае их обнаружения, принять меры по их удалению из поисковой выдачи, потому что они негативно влияют на продвижение сайта. Из-за этого, сайт может попасть под санкции поисковых систем.